一、电镜集群用户计算资源配置

1、管理/登录节点

ip:10.15.56.103

登录方法:

打开terminal终端软件,windows电脑推荐使用MobaXterm,mac或linux电脑使用自带 terminal

- 通过云桌面登录或玻璃房support PC 登录:ssh 账号@10.15.56.103

- 通过校园网登录:ssh 账号@10.15.56.103 –p 10086

注意事项:

管理节点上

允许:

- 浏览/移动/拷贝/编辑 文件

- 编辑作业脚本

- 通过Slurm提交作业

- 检查作业状态

不允许:

- 运行作业

- 多进程下载大量数据

2、计算节点

CPU节点:16个

- 每节点两个cpu,每节点含28个核

- 每8个节点分为一个队列,分别为cpu-1,cpu-2

GPU节点:8* 4卡P100节点 & 6* 4卡P40节点 & 19*4 卡A40节点。

- P100卡的前6个节点为GPU-A队列,后两个节点分别为cryosparc1与cryosparc2队列。

- P40节点,其他五个做为GPU-B队列,一个作为cryosparc3 队列。

- A40节点,16个作为GPU_C队列,其余三个分别为cryosparc_c-1,cryosparc_c-2,cryosparc_c-3队列。

FAT节点:三个,

- 一个64核,2TB内存,队列名FAT

- 两个各64核,1TB内存,队列名BIG_MEM

二、修改账户密码的方法

为了数据安全考虑,用户在集群上的账户在首次登陆之后应该及时修改密码,修改密码有两种方式:

1,命令行方式:

使用passwd命令,首先用原密码登录账号,之后使用该命令按要求输入原密码及新密码即可。

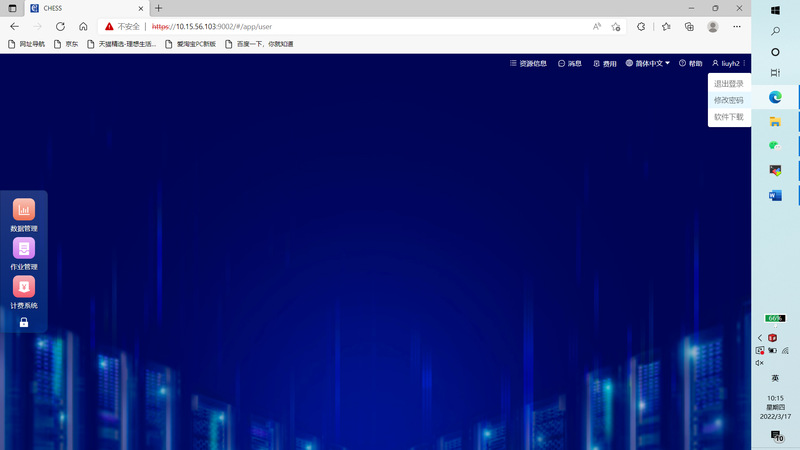

2,集群管理系统方式:使用浏览器登录 https://10.15.56.103:9002

输入集群的用户账号以及密码,进入chess管理网页,在右上角账户下面选择修改密码,进行密码修改操作:

最后点击保存,至此集群账号密码修改成功。

建议用户养成定期修改密码的习惯,并且尽量选择比较复杂的密码,以保护所属数据的安全性。

三、用户提交作业方式

提交作业分为三种方式:CHESS平台提交、终端文本提交、应用软件UI界面提交。首先无论以何种方式提交作业,应用软件必须先安装在集群上。

常用的提交作业方式:

- 终端文本提交

1.1 登录终端,使用mobaxterm 选择ssh 然后使用个人账户登录集群管理节点

1.2 编写提交脚本,脚本名称可以自定义,这里使用1.slurm

脚本内容为:

#! /bin/bash #SBATCH -J test ###指定作业名称 #SBATCH -p GPU-A ### 指定队列名称 #SBATCH -t hh:mm:ss ### 指定本次作业运行的最大时长 #SBATCH --gres=gpu:tesla:x ###指定使用gpu的个数,x为数字 #SBATCH -n x ###指定使用的核数 #SBATCH -N x ###指定使用的节点数

#Command Mpirun -n x --machinefile ./host.txt relion

|

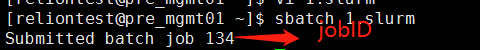

1.3 提交作业

sbatch 1.slurm

输出的信息为:

1.4 查看作业,根据上面的输出查找对应的jobID

squeue

1.5 查看作业详情

scontrol show job <job_id>

1.6 删除指定作业

scancel <job_id>

- 应用软件GUI界面提交

需要根据软件特性做相应配置,具体见后面几种常用软件提交作业用法。

四、relion在集群中的使用方法

目前集群中安装的relion版本有:relion2.0,relion3.03,relion3.1-beta,relion3.1.3,relion-4.0.1-cuda-11.6 (module load relion/4.0.1-cuda11.6; 只能使用GPU- C队列),可以使用module av命令查看可以调用的版本。

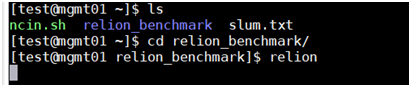

1、登录集群,调用relion相应模块

2、进入到数据所在的文件夹,调用relion。注意:一定要cd到要计算的数据所在文件夹后再调用relion!

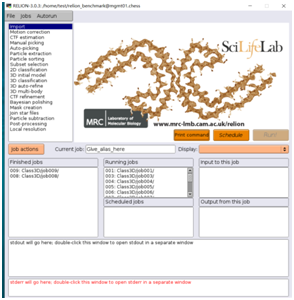

3 提交作业方法:

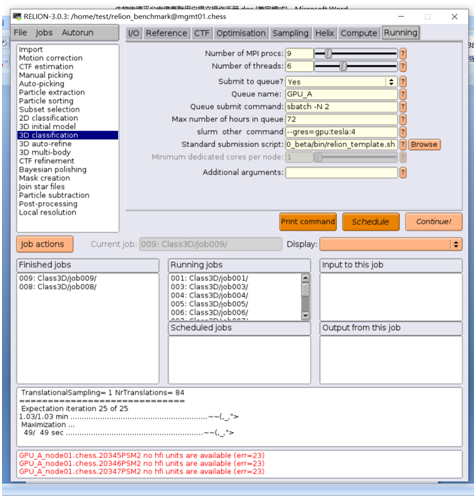

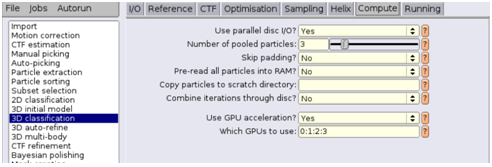

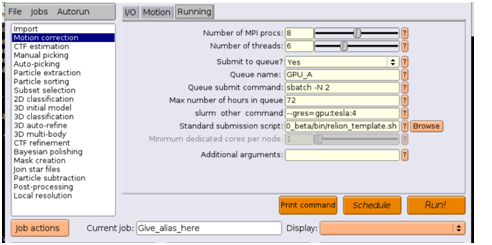

a) 实例一:以其中一个3D classification任务为例,以下参数设置方法是使用GPU-A队列中的两个节点,并且申请所有的八张GPU卡。

关键参数:

Submit to queue? 一定要选Yes,如此该任务才会提交到计算节点上运行,否则会在管理节点运行。

如果申请一个GPU节点,相应参数改为:

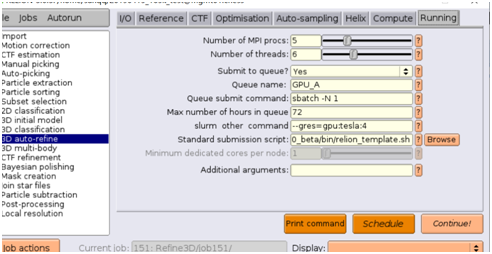

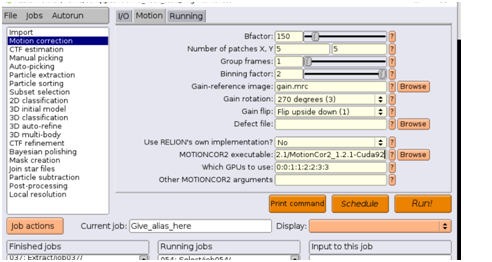

b)实例2:以motion correction任务为例,以下任务申请两个GPU节点,使用8张卡

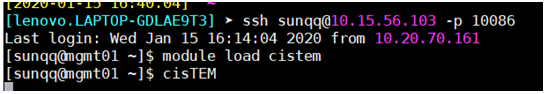

五、cisTEM在集群中的使用方法

- 登陆 管理节点 10.15.56.103,并运行:

module load cistem

cisTEM

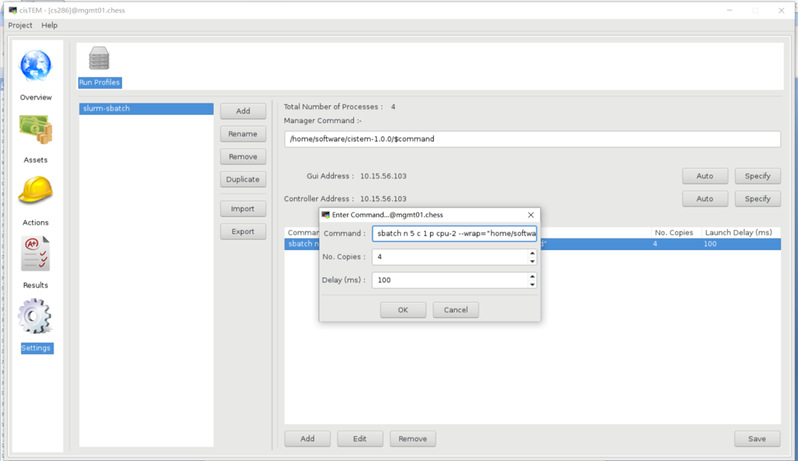

之后打开已有project或者新建project,点击 左栏的 settings:

在打开的Gui窗口里设置settings:

1 在左边窗口处点击 rename,将当前profile名字改为 slurm-sbatch(也可选用其他名字)

2 点击右边窗口的Specify按钮,分别将GUI Address与Controller Address 改为登陆节点IP: 10.15.56.103

3 双击Command下面的蓝条,可以进入编辑命令状态

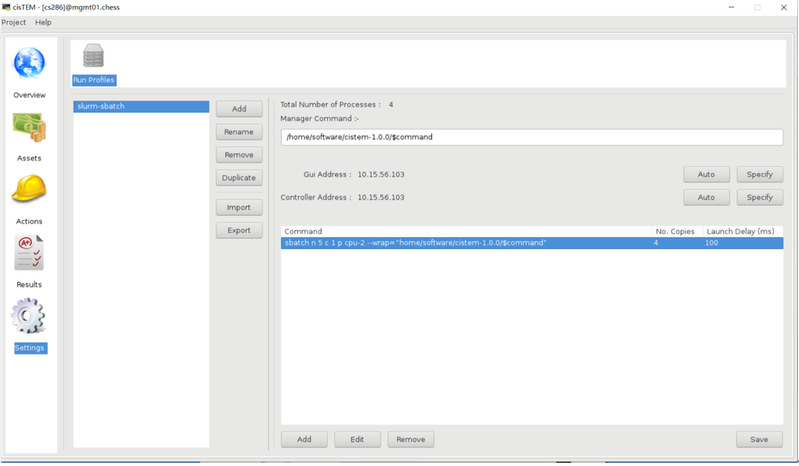

编辑完命令,点击 OK,GUI窗口内容此时如下:

4、此时点击右下角 save 保存。切记一定要保存,尤其首次使用cisTEM时,否则就会在管理节点上跑任务。

后续每次调整该提交命令中的参数之后都需点击 save。

提交作业命令示例1:

sbatch –n 5 –c 1 –p cpu-2 --wrap=”home/software/cistem-1.0.0/$command”

No copies 为4

命令含义:5个任务,每个任务使用1个核,在cpu-2队列上执行。

并复制4个提交命令,也即产生4个作业,有4个不同的jobid。

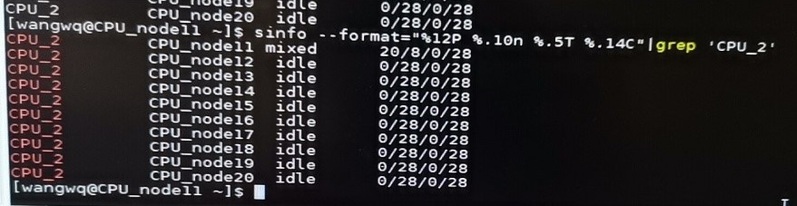

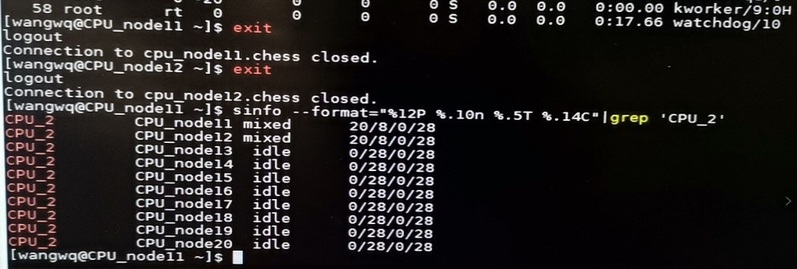

使用如下命令可以查看队列cpu-2 上的使用核的情况

sinfo --format="%12P %.10n %.5T %.14C" |grep 'cpu-2'

显示:

提交作业命令 多节点示例2:

将提交作业的命令改为

sbatch –n 5 –c 2 –p cpu-2 --wrap="home/software/cistem-1.0.0/$command"

No copies 为4

命令含义:5个任务,每个任务使用2个核,在队列cpu-2上执行。

产生四个jobid

每个作业使用10个核。4个作业使用40个核,因为每个节点28个核,所以提交任务后 squeue 显示分配2节点。

同样使用命令查看cpu-2上的使用核的情况

sinfo --format="%12P %.10n %.5T %.14C" |grep 'cpu-2'

显示:

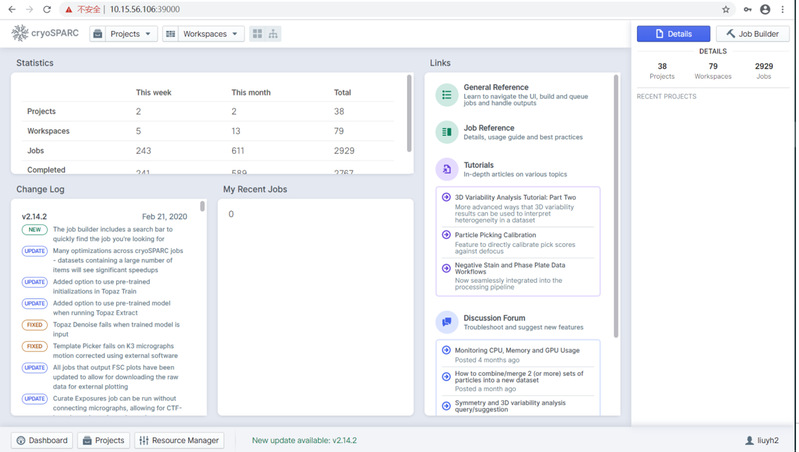

六、cryoSPARC在集群中的使用方法

目前集群中有专门的三个节点 gpu-a-node07.chess 与 gpu-a-node08.chess , gpu-b-node06.chess 分别作为队列 cryosparc-1与cryosparc-2,cryosparc-3 运行用户的 cryoSPARC 作业。

使用 cryoSPARC 前,用户需要先向集群管理员申请账号,并向管理员说明处理数据所在位置,由管理员修改文件夹权限,增加 cryoSPARC 管理员读写权限。

1、使用浏览器(推荐google chrome)登录 10.15.56.142:45000

使用申请到的账号密码登录之后,显示如下:

2、点击 Projects-Add

|

新建project。

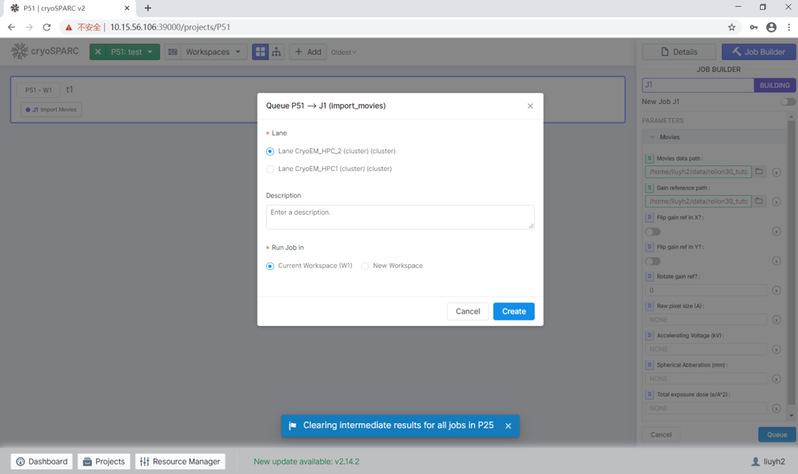

3、提交作业

目前集群有三个节点队列作为 cryoSPARC 专门队列,提交作业时点击右下角的 queue 按钮,出现选择队列的对话框,用户可以根据队列的忙闲程度选择,之后点击Create按钮。

IMOD使用方法

$module load IMOD/4.11.24

$imod

Gromacs使用方法

gromacs是在gpu-c队列的节点上编译的 所以使用也请提交到gpu-c队列

$ module load gromacs-2021.3-cuda11.6

默认会加载intel2021 gcc10.1 cuda11.6 以及gromacs自身变量